Microsoftova inovacija u borbi protiv AI halucinacija

- 25 sep 2024

- Petar

U svetu veštačke inteligencije, AI halucinacije predstavljaju značajan izazov za razvoj pouzdanih sistema. Microsoft je nedavno predstavio revolucionarno rešenje za ovaj problem, demonstrirajući svoj kontinuirani napredak u oblasti generativne veštačke inteligencije.

Razumevanje AI halucinacija i njihovog uticaja

AI halucinacije su fenomen gde veliki jezički modeli (LLM) generišu netačne ili izmišljene informacije, uprkos opsežnom treningu. Ovaj problem je široko rasprostranjen u industriji, utičući na performanse različitih AI alata, uključujući one koje su razvili giganti poput OpenAI-a, Meta-e i Google-a.

Prema istraživanju Univerziteta Stanford, AI sistemi prave greške u čak 75% slučajeva kada odgovaraju na pravna pitanja. Ovo ilustruje ozbiljnost problema i potrebu za pouzdanijim rešenjima u oblasti generativne veštačke inteligencije.

Microsoft-ova inovativna solucija: Correction

Kao odgovor na ovaj izazov, Microsoft je lansirao Correction, inovativnu funkciju u okviru svog postojećeg Azure AI Content Safety alata. Ova tehnologija je dizajnirana da identifikuje i ispravi AI odgovore koji nisu direktno povezani sa izvorima podataka korišćenim za trening LLM-a.

Correction radi na sledeći način:

- Prvo označava neutemeljen sadržaj

- Zatim inicira proces prepisivanja u realnom vremenu

- Revidira netačne delove kako bi se osiguralo poravnanje sa povezanim izvorima podataka

- Vraća ispravljeni sadržaj korisniku

Važno je napomenuti da se ovaj proces odvija pre nego što korisnik vidi početni neutemeljen sadržaj, čime se značajno poboljšava pouzdanost AI generisanih odgovora.

Širi kontekst i implikacije

Microsoft-ova inicijativa dolazi u trenutku kada industrija veštačke inteligencije intenzivno traži rešenja za problem halucinacija. Analitičari iz Gartner-a sugerišu da, iako dodatni alati mogu pomoći u proveri tačnosti LLM izlaza, upotreba boljih tehnika pretraživanja za RAG ili utemeljenje treba da bude prvi korak u ublažavanju halucinacija.

RAG je metoda stvaranja prilagođenijeg genAI modela kroz niz pitanja i odgovora pruženih LLM-u, što omogućava preciznije i specifičnije odgovore na upite. Ova tehnika se pokazala kao obećavajuća u poboljšanju pouzdanosti AI sistema.

Izazovi i budući pravci

Uprkos obećavajućim rezultatima, analitičari ostaju oprezni u pogledu efikasnosti alata poput Correction-a u potpunom eliminisanju grešaka. Jason Wong, potpredsednik analitičar u Gartner-u, ističe da nijedan od trenutnih proizvoda ne obećava potpuno eliminisanje halucinacija ili dostizanje određenih pragova tačnosti.

Optimizacija infrastrukture za pretraživanje inkorporiranjem i leksičkog i semantičkog pretraživanja povećava verovatnoću da se LLM-u prosleđuju samo relevantne informacije. Međutim, čak i ovo ne može u potpunosti eliminisati halucinacije.

Kvalitet informacija dobijenih za RAG u velikoj meri određuje kvalitet izlaza, čineći upravljanje sadržajem i upravljanje suštinskim za minimiziranje halucinacija. Ovo naglašava potrebu za holističkim pristupom problemu AI halucinacija, koji kombinuje napredne tehnologije sa robusnim praksama upravljanja podacima.

Zaključak

Microsoft-ov Correction predstavlja značajan korak napred u borbi protiv AI halucinacija. Dok izazovi ostaju, ovakve inovacije pokazuju obećavajući put ka pouzdanijoj i preciznijoj generativnoj veštačkoj inteligenciji, otvarajući nove mogućnosti za primenu AI u različitim industrijama.

Petar

Petar je student elektrotehnike na Univerzitetu u Nišu i entuzijasta za sve što je povezano sa novim tehnologijama. Njegovi članci pokrivaju širok spektar tema, od tehnoloških inovacija do kulturnih trendova. U slobodno vreme, Petar se bavi programiranjem i istraživanjem novih tehnoloških rešenja.

Veštačka inteligencija

Veštačka inteligencija i budućnost liderstva u poslovanju

- 01 oct 2024

- Miloš

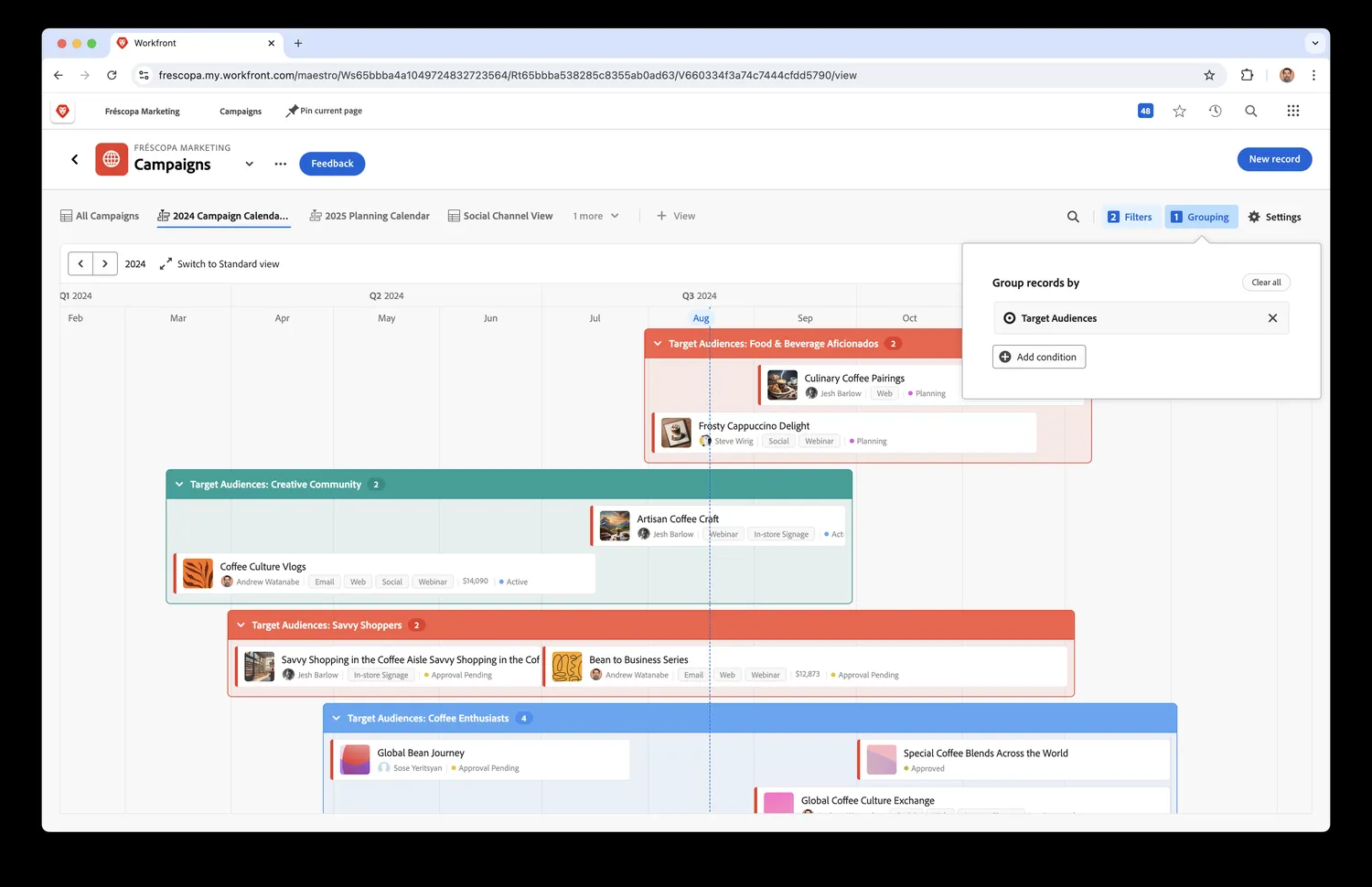

Adobe-ov novi Workfront alat revolucioniše planiranje marketinga

- 28 aug 2024

- Petar

Intel suočen sa izazovima u AI trci i finansijskim teškoćama

- 03 sep 2024

- Aleksandra